ユサコ主催のEx Libris bXセミナーに行ってきました。この手のセミナーに参加する、いや出張自体が久しぶりなので開放感にあふれています。うひゃっほう!

今日の目玉はPrimoとbXの紹介。先にbXのサマリを。

- 目指すものはレコメンドサービス。

- 万単位のユーザから得られた1000万件以上のさまざまなリソースへの情報要求の分析が基盤

- 論文単位の要求に応えられる。

- さまざまな環境に適応させることで、学術検索と密に統合し容易に利用可能。

- 各種標準への準拠と相互運用性の確保。

セミナーはまずEx Librisの紹介から。以下まとめ。

- 図書館システム(Aleph)からリンクリゾリバ(SFX)、メタサーチ(MetaLib)、統合インターフェース(Primo)などトータルラインナップを用意している。

- Hi-endな顧客をターゲットとし、顧客とのコラボレーション、緊密な連携を保っている。

- 導入実績:

- 米国のトップ10の大学全て

- 米国のトップ50のうち45の大学

- 欧州のトップ50のうち36の大学

- 37の国立図書館 など

- 76%のスタッフを研究開発に振り向けるなど、常に次世代への投資を怠らない。

- 図書館以外への検索要求の増加というパラダイムシフトが背景にある。

- OpenURLなど標準策定への参画

- ユーザグループとの連携

- OpenPlatformとユーザコミュニティによる拡張

OpenPlatformあたりの話題は、カレントアウェアネス-R(2008.7.11)でも報じられていたところです。

これら公開された情報を元に、ユーザが開発したライブラリはEL Commonsと呼ばれるコミュニティサイト(ユーザのみ公開)で公開されています。「うちはOpenPlatformだから」という説明はこの後何度か出てきましたので、ポイントの一つかもしれません。

次はPrimoの紹介。こちらは日本語で。

- 機関でアクセスできるリソースを一元的に提供する窓口(ポータル)

- 自機関のみ・紙媒体のみが対象である従来のOPACよりも対象・機能共に大(次世代OPAC)

- PrimoツールバーやOpenSearchによりブラウザからいつでも検索

「次世代OPAC」と自称するだけあり、検索結果のファセットクラスタリング(エンジンはMetaLibと同じvivisimo)、検索結果へのtagging、タグクラウド、自館だけでなく他の目録、google books、amazonなど他のアクセスポイントなどへのリンク、など一般的な機能は一通り抑えています。

「使ってみてえ」という方は、the British Library とか オックスフォード大学図書館 あたりでお試しください。(ソースはやっぱりカレントアウェアネス-R(2009.3.3)。いつもありがとうございます。)

Primoのシステム構成ですが、バックエンド(Publishing Platform)とフロントエンド(User Experience)の2階層構造で、先に紹介した機能がフロントエンドにあたります。

バックエンド(Publishing Platform)側では、ローカル情報源(図書館システム、機関リポジトリ、SFX・MetaLibのKnowledgeBase(電子ジャーナルやデータベースのURL、利用条件など))、その他ハーベスト可能なものは事前にハーベストし、Primo Normalized XML(PNX)レコードを作製します(FRBR対応!)。このPNXを元に重複除去や元データの拡張(amazonから表紙画像をもらってくるとか)を行い、Primoのインデックスとなります。ハーベスト対象にはDigiTool、Dspace、Fedoraといった機関リポジトリにも対応とのこと。

従来のMetaLibのようなメタサーチでも検索結果の重複除去などの機能はありましたが、Primoではデータをハーベストしてレコードの正規化までしてしまうのですね。

ハーベストできないリソースについては最適化もできないので従来のメタサーチをするしかないのか、と考えてしまいましたが、

- レスポンスが早くない

- ランキングやファセットの精度が上がらない

ことを解消するため、メタサーチの際に「Primo仕様の検索式を投げ、PNXでデータを返戻」するための仕様を公開しているそうです。(内容を詳しく質問したら「EL Commonsにサンプルコードがあるから見て」とのことでした。)

Primoは現在3500万レコードまでをサポート、160以上の顧客があり、現在は対応言語の拡大を図っているそうです。(日本語は対応準備中、でも日本語カタログは配られていました。)

AquaBrowserなど競合他社製品との相違点を質問しましたが、「詳細は承知していない」ながらも「APIやSDK公開など、OpenPlatformである点は大きく異なる」としていました。

確かに、EL Commonsではユーザが作った拡張アプリ、ユーティリティなどがあり、「ユーザ参加」型の開発姿勢が伺えます。(でも、それはHi-endな大学図書館等に優秀なSystem Librarianがいて、それで始めてできる技だよなあ。)

コーヒーブレイクの後はいよいよbXについて。こちらは逐次通訳。

- ユーザがどのようなコンテンツを作成したか、またユーザが何をしたかがフォローされ、重要視されつつある。

- 結果、図書館の利用データに価値が生じた。正に金の鉱脈ともいえる。

- インパクトファクターでの評価には分野の限定やタイムラグなどの問題がある。

- 学術論文の電子化は、単にPDFやHTMLに媒体が変わっただけでなく、メディアの多様化ももたらした。

- しかし、論文の評価手法は引用分析など、紙ペースの手法のまま。

- そこでレコメンド。

- 図書館の中で必要性が生まれたが、EBCSO、LibraryThingsなど今までのシステムではタイトルを表示する程度の機能しか持たない。

- 学術分野に求められているのは「論文」レベルのレコメンド。

- 「人気」に基づくものではなく、利用状況の分析に立脚したもの。

このあたりを背景に、Ex LibrisではLos Alamos研と独占的契約を結び、2007年からbXの研究開発に着手。

- ネットワーク化された研究コミュニティの力を利用して、論文の利用に応じたレコメンデーションを行う。

- 複数の図書館での利用状況を統合、これを分析する。

- この研究はLos Alamos研の Johan Bollen と Herbert Van de Somple (発表者注: OAI-PMHの作成などに貢献)によって行われた。

- この研究の詳細は2人による次の論文を参照されたい。 Johan Bollen, Herbert Van de Somple. "An architecture for aggregation and analysis of scholarly usage data." http://public.lanl.gov/herbertv/papers/jcdl06_accepted_version.pdf (last access: 2009-04-20)

- 1億件以上(!)のSFXのログデータを収集、これを元に分析を行った。

- リンクリゾルバはOpenURLを介して接続された各種のリソース間のハブと言える。

- これを「OpenURL Linking Layer」と「Resource Layer」の2階層と捉える。

- OpenURLは2001年にSFXが実装、2009年現在では3000以上(うち1800以上はSFX)のリンクリゾルバのみならず多くの学術情報同士のリンキングに利用されている。

- リンクリゾルバがリソース間のハブとなっている。

- bXはこのアーキテクチャの上に構築されている。

- 複数の「OpenURL Linking Layer」(=大量のSFXのデータ)をOAI-PMHで吸い上げる「Recommender Service Layer」を構築。ここにbXが位置する。

- データ取得は、欧米の各大学より協力を得た。最大の開発パートナーはLos Alamos研。

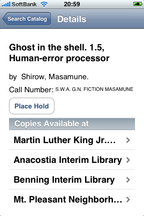

bXのデモ。SFX上に、通常の電子ジャーナルなどのリンク解決だけでなく、レコメンドする論文を表示。例では、EBSCOからSFXへリンク、そこから別のアグリゲータの論文がレコメンドされ参照する様子が紹介されました。

また、bXが単にSFXと共に利用できるだけでなく、Open Interfaceを持ち

- OpenURL/XML

- OpenURL/RSS

- OpenURL/ATOM

など各種のシステムから呼び出せる、という事例も。XML Responsの例は資料にあったのですが、字が細かくてかろうじて判別…困難。

例えば、MetaLibのXML APIである x-server の実装、xerxes 上にbXのレコメンドを表示させる例なども紹介されていました。(後で聞いたら「It's so easy. Like SFX.」といっていた。うちもやろう。)

実際の計算というか分析方法は、大まかには次のとおり。

- SFX経由でアクセスした、同じユーザの一定時間の検索行動を取得

- その行動の中でアクセスした論文を、順や回数などの要素で重み付け(クリック回数などの閾値は設定しているらしい)。

- 別にユーザに対して、先に利用された論文があれば同じ検索行動内で取得した論文をレコメンド対象として提示。

- 詳しくは先の論文に手法を載せてあるので参照されたい。

意外とシンプル。しかし、バックにあるのは一億件のデータ。正確度はどうなのだろう?

質疑応答でこのあたりについても触れられていました。

- どうレコメンドするか、例えば自組織のデータを教師データとするか、bX全体のデータを利用するかなどの設定はできるようにしてある。

- 全ての分野をカバーしてはいない。論文のカバー率は20%強。この中からレコメンドすることになるが、参加館が増えればデータも増えるだろう。

- レコメンドデータの評価についても研究を進めている。

- bXの利用については、SFX他Ex Librisの製品導入が前提ではない。また、SFX利用データの提供の義務も考えていない。

- プライバシー保護には特に配慮している。各所のSFXから収集したデータからIPアドレス等は削除、bX内では暗号化されており外部から元データの出所を知るすべはない。

- 規模の大小、分野に特化しているか否かで適切なレコメンドができるかどうかは変わってくる。(具体的な値については触れていませんでした。)

- 今後は、論文のトレンド分析やユーザの行動追跡にも利用できるのではないか。実際に、恣意的に行われることがある引用の分析より実態に近いデータを得られている。

bX。Launchは来月とのこと。日本での発売の詳細についてはアナウンスがありませんでしたが、期待して待つことにします。

以下個人的な雑感とかなんとか。

そもそもうちはEx Librisが仰る所の「Hi-end」なユーザなのだろうか。泡沫ユーザな気もしないでもなくはない。ちょっとはユーザコミュニティに貢献しないと。

SFXのログデータを分析すればレコメンドも……と軽く考えていましたが、2年も前に手をつけられていたのですね。それはそうか。複数のSFXのデータの統合までは考えていませんでした。でも計算はどうやって。イスラエルの片隅のデータセンターでクラスタマシンが唸りをあげているのでしょうか。

リンクリゾルバは情報のハブ。確かにそのとおり。OpenURL様様です。そして、そのハブに流れる情報を全て吸い上げようとするbX。レコメンドという利便と引き換えになるものは何か。タダで質の高い情報は得られない。標準化は協調なのか連携なのか独占なのか。泡沫情報プロバイダはオリジナリティとアイデンティティをどう保つか。昨今のPORTAやJ-Globalやその他もろもろの動きを見ているとそう感じます。

と、長々書いていたらARGが配信される時間になりました。今週は[ARG-371]です。どれどれ…。

なお、まだ情報が出ていないが、6月上旬に開催される国立情報学研究所(NII)のオープンハウスにも参加する。

・国立情報学研究所(NII) - オープンハウス

http://www.nii.ac.jp/index.php?action=pages_view_main&page_id=317

あ、今年もあるんだ。オープンハウス。リンク先を開こう。今年もコンテンツ系のワークショップも…あああああ!これは!!

6月12日(金) [特別会議室] 次世代学術コンテンツ基盤ワークショップ

11:00〜12:30 「電子リソースアーカイブの展望」

14:00〜16:00 「ひらめき、ひろがる、知の可能性(かたち) - CiNiiリニューアルとウェブAPIコンテスト -」

あう、「ウェブAPIコンテスト」ってなにい? どういうこと?

そうか、その手があったのか…API普及のために…コンテスト…うちがやっても商品出せないぞ…いやチャレンジするとかしないとか考えようよ自分。早くOPAC直して。

Firefoxでアクセスすれば、

Firefoxでアクセスすれば、