レファレンスライブラリアンこそ我が本務(本当)

2006/11/01

俺はReferencerだ。真面目なReferencerだ。

「レファレンス係長」を拝命している以上、職種を聞かれればレファレンスライブラリアンと答えるだろう。システム周りのことは…まあ、少人数の職場なのでそれなりに関わりがある、ということにしておいて欲しい図書館退屈男である。

レファレンスには日々の修練が必要だ。だから国立国会図書館レファレンス協同データベース事業研修会(東京本館開催)に参加することになった。

まず事前課題。レファレンス事例か調べ方マニュアルを作成して期限までにデータベースに登録、追って講師からコメントすると告げられた。どの事例を入力すればいいのか。悩みつつ事例を選び、入力。「回答プロセス」も忘れかけていたが、メモを頼りに記憶をたどり、入力。締め切りの数日後、講師からの「こういうレファレンスツールがある」とのコメントを頂いた。ああ、ツールさえ揃っていれば、と蔵書の不備を痛感するも、あっても使いこなせなければ意味が無いと悟る。

そして研修会当日。まずは事業の概要から。現在、レファレンス事例については2万件以上が蓄積され、そのうち1万件が一般公開されているという。また、都道府県立クラスの図書館では、過去に蓄積された事例データの遡及入力を進めており、これがコアになっていると聞く。とはいえ、通常の事例入力は参加館1館あたり月1件以下とのことで、できるだけ入力をお願いしたいとのこと。

主題別の登録数についても説明があり、郷土関係、歴史上の人物に関するレファレンスが多いためか歴史、社会科学の事例が多くなっていると推定されている。弊社の主題範囲である農業を含む産業分野の入力は少ない。データベースにはNDCベースの主題ごとのメニューが用意されているが、 農業(65) - 園芸(49) - 蚕糸業(2) - 畜産業(19) - 林業(18) - 水産業(12) (カッコ内はエントリ投稿時の一般公開件数)というのは少なくはないのか。衰退しているとはいえ蚕糸業に至ってはわずか2件だ。

データベースそのものについては、図書館員にはレファレンスの情報源のほかサービスのPRの素材として、一般利用者には調べ物の情報源として、また研究者には図書館情報学その他の研究素材としての活用が考えられる。そのためにこれらの様々な利用者を考慮し、的確なキーワードの付与や克明な回答プロセスの入力など質の高いデータ入力の必要性について講師から説明があった。参加館が増えるにつれ、質の維持は困難になってゆくと思われるが、運営側には敷居を低くし「とりあえず事業に参加し、事例を入力してほしい」と言う意思が感じられた。

講師各位(午前の講師の方とは以前関西館にてお付き合いいただいた。実は以前からの知り合いだったりするが、世間は狭い。)と昼食の後、午後は具体的にデータの品質を維持するための手法について、事前課題をベースに解説が進められた。特に印象に残ったのは、「『さすが』と手を打つ事例データ」とは何かと言う点。他者が「読みやすい」データであることはもちろん、

- 丁寧な書誌データ

- URLと確認年月日

- 難読語に対する「よみがな」付与

- 背景、状況が確認ができる記述

などがそのポイントとして挙げられた。この考え方は他のデータベースにも通じるところがある。

後半はグループ別討議。主に専門図書館の方と同席になり、レファレンスサービスの改善について話し合う。

- 実質1人で図書室を運営しているが、図書館界の情勢変化を把握し、自社の出版事業に反映させるために参加している。負担にはなるが、必要なことだと考えている。

- 1人で運営していたときは、自分だけが過去の事例を把握していればいいので記録はおろそかになる。これが、スタッフの増員がありノウハウを共有、蓄積するためにこの事業に参加した。

- 専門図書館の事例はNDLから見てもとても参考になる。「餅は餅屋」と言う言葉がぴったり。一般から見れば専門性は高く難しいと捕らえられるかもしれないが、図書館員としては有用なデータと言える。

など、それぞれの立場でのプロの司書のスピリッツを感じる発言も聞かれた。弊社はどうだろう。正直、半ば「様子見」で参加した部分もあるが、6門「産業」のデータの少なさを見ると、この分野の一翼を担う専門図書館として、事業への積極的な関与を考えたほうがよいだろう。

その他のグループからは、一旦入力された事例データの経年による陳腐化の懸念とメンテナンスの必要性が挙げられた。時々刻々と変化するソースもある。それがインターネット上の情報であればなおさらだ。こまめに確認をするしかないのだろうが、入力件数が増えれば増えるほど困難になるのかもしれない。メンテナンスをし続けるデータベース。運営は困難だろうが、それが必要と言うのならやるしかない。できれば精神論ではなく効率的な方法を模索したいと考える。

終了後は茶話会(アルコール抜きね)。こういう交流の機会もまた円滑な事業のバックボーンになるので無視できない。参加した方々と弊社のレファレンス事例と研究成果について語っていると「よく覚えていますね」とお褒めに預かる。少々おしゃべりが過ぎたようだが、レファレンス事例についてはともかく、研究成果と活用事例はいわば自社の大事な商品。これをあらゆる場で広報するのは、全社に課せられた重要なミッションと考えている。

そして今、事後課題の「自館のレファレンスサービスの効率化についての方策の検討」などについて考察中。ターゲットはどこか、レファレンスとして受ける可能性のある問いは何か、そんなところから考えてみることにしよう。

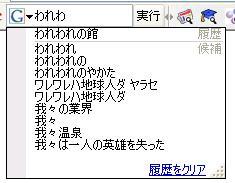

Googleツールバー4。キーワードを検索窓に入力すると履歴と候補を示してくれます。

Googleツールバー4。キーワードを検索窓に入力すると履歴と候補を示してくれます。